Съдържание:

- Автор Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:43.

- Последно модифициран 2025-01-22 17:18.

Събирай (Действие) - Връща всички елементи от набора от данни като масив в програмата на драйвера. Това обикновено е полезно след филтър или друга операция, която връща достатъчно малко подмножество от данни.

По този начин какво е PySpark?

PySpark Програмиране. PySpark е сътрудничеството на Apache Spark и Python. Apache Spark е рамка за клъстерни изчисления с отворен код, изградена около скорост, лекота на използване и поточно анализиране, докато Python е език за програмиране с общо предназначение и високо ниво.

Също така, какво е карта в PySpark? Искра Карта Трансформация. А карта е операция за трансформация в Apache Spark. Прилага се за всеки елемент на RDD и връща резултата като нов RDD. Карта трансформира RDD с дължина N в друг RDD с дължина N. Входните и изходните RDD обикновено имат същия брой записи.

По този начин какво е SparkContext в PySpark?

PySpark - SparkContext . Реклами. SparkContext е входната точка към който и да е искра функционалност. Когато стартираме някоя Искра приложение, стартира програма за драйвер, която има основната функция и вашата SparkContext се инициира тук. След това програмата на драйвера изпълнява операциите вътре в изпълнителите на работни възли.

Как да проверя версията на PySpark?

2 отговора

- Отворете Spark shell Terminal и въведете команда.

- sc.version Или spark-submit --version.

- Най-лесният начин е просто да стартирате "spark-shell" в командния ред. Той ще покаже.

- текущата активна версия на Spark.

Препоръчано:

Какво е w3c какво е Whatwg?

Работната група по технологии за уеб хипертекстови приложения (WHATWG) е общност от хора, които се интересуват от развитието на HTML и свързаните с него технологии. WHATWG е основана от лица от Apple Inc., Mozilla Foundation и Opera Software, водещи доставчици на уеб браузъри, през 2004 г

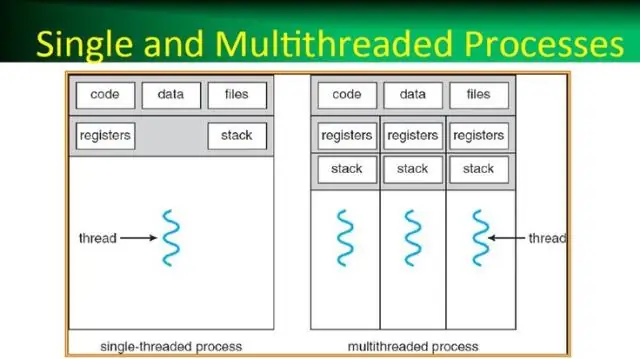

Какво е процес в операционна система какво е нишка в операционна система?

Процесът, най-просто казано, е изпълняваща се програма. Една или повече нишки се изпълняват в контекста на процеса. Нишката е основната единица, на която операционната система разпределя процесорното време. Пулът от нишки се използва основно за намаляване на броя на нишките на приложения и осигуряване на управление на работните нишки

Какво е персонален компютър Какво е съкращението?

PC - Това е съкращението за персонален компютър

Как да направя PySpark DataFrame от списък?

Следвам тези стъпки за създаване на DataFrame от списък с кортежи: Създайте списък с кортежи. Всеки кортеж съдържа име на човек с възраст. Създайте RDD от списъка по-горе. Преобразувайте всеки кортеж в ред. Създайте DataFrame, като приложите createDataFrame върху RDD с помощта на sqlContext

Какво е ред в PySpark?

Ред в SchemaRDD. Полетата в него могат да бъдат достъпни като атрибути. Редът може да се използва за създаване на обект на ред чрез използване на именувани аргументи, полетата ще бъдат сортирани по имена