- Автор Lynn Donovan [email protected].

- Public 2023-12-15 23:43.

- Последно модифициран 2025-01-22 17:18.

Конфигурационните файлове, които трябва да бъдат актуализирани, за да се настрои напълно разпространен режим на Hadoop, са:

- Hadoop-env.sh.

- Основен сайт. xml.

- HDfs-сайт. xml.

- Мапред-сайт. xml.

- майстори.

- Роби.

Освен това, кои са важните конфигурационни файлове в Hadoop?

Конфигурацията на Hadoop се управлява от два типа важни конфигурационни файлове:

- Конфигурация по подразбиране само за четене - src/core/core-default. xml, src/hdfs/hdfs по подразбиране. xml и src/mapred/mapred-default. xml.

- Конфигурация, специфична за сайта - conf/core-site. xml, conf/hdfs-сайт. xml и conf/mapred-site. xml.

По подобен начин кое от следните съдържа конфигурация за HDFS демони? xml съдържа конфигурация настройки на HDFS демони (т.е. NameNode, DataNode, Secondary NameNode). Той също така включва коефициента на репликация и размера на блока на HDFS.

какво представляват конфигурационните файлове в Hadoop?

Конфигурационни файлове са файлове които се намират в извлечения катран. gz файл в др/ hadoop / директория. всичко Конфигурационни файлове в Hadoop са изброени по-долу, 1) HADOOP -ENV.sh->>Той определя променливите на средата, които влияят на JDK, използван от Hadoop Демон (bin/ hadoop ).

Кои файлове се занимават с проблеми с малки файлове в Hadoop?

1) HAR ( Hadoop Архив) Файлове е въведено в справяне с проблем с малък файл . HAR въведе слой отгоре HDFS , които предоставят интерфейс за файл достъп. Използвайки Hadoop команда за архивиране, HAR файлове са създадени, които изпълняват a MapReduce работа да опаковам файлове се архивира в по-малък брой HDFS файлове.

Препоръчано:

Кои са основните конфигурационни параметри, които потребителят трябва да посочи, за да изпълни заданието на MapReduce?

Основните конфигурационни параметри, които потребителите трябва да посочат в рамката “MapReduce” са: Местоположенията на входа на заданието в разпределената файлова система. Изходното местоположение на заданието в разпределената файлова система. Формат за въвеждане на данни. Изходен формат на данните. Клас, съдържащ функцията map. Клас, съдържащ функцията за намаляване

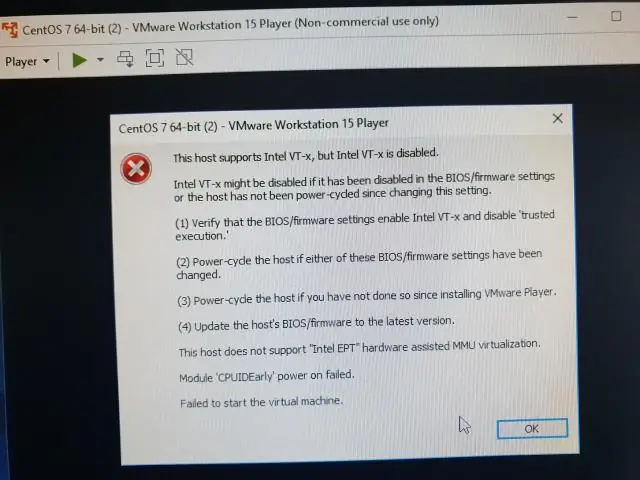

Кои опции трябва да бъдат активирани, за да стартирате Hyper V?

Въпрос 2 Кои хардуерни опции трябва да бъдат активирани, за да се стартира Hyper-V? Опцията за хардуерна хардуерна виртуализация (Intel VT/AMD-V) и предотвратяване на изпълнение на данни (Intel DX/AMD NX) трябва да бъдат активирани, за да стартирате Hyper-V

Кои три технологии трябва да бъдат включени в SOC?

Кои три технологии трябва да бъдат включени в системата за управление на информация за сигурност и събития на SOC? (Изберете три.) Прокси сървър, удостоверяване на потребител и системи за предотвратяване на проникване (IPS) са устройства за сигурност и механизми, разположени в мрежовата инфраструктура и управлявани от центъра за мрежови операции (NOC)

Можем ли да имаме множество конфигурационни файлове на приложения?

Не можете да използвате множество конфигурационни файлове (т.е. по един за проект на библиотека) без кодиране. Опция: Можете да използвате класа ConfigurationManager, за да заредите алтернативен конфигурационен файл по код

Какво представляват бележките на говорещите да напишат целта си и кои са ключовите неща, които трябва да запомните за бележките на говорещите?

Бележките на говорещите са текст с ръководство, който презентаторът използва, докато представя презентация. Те помагат на водещия да си припомни важни точки, докато прави презентация. Те се появяват на слайда и могат да бъдат видени само от водещия, а не от публиката