- Автор Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:43.

- Последно модифициран 2025-06-01 05:07.

Анализ на големи данни е често сложен процес на изследване голям и разнообразна данни комплекти, или голяма информация , за разкриване на информация - като скрити модели, неизвестни корелации, пазарни тенденции и предпочитания на клиентите - която може да помогне на организациите да вземат информирани бизнес решения.

Съответно какво се изисква за анализ на големи данни?

1) Програмиране Не са зададени много стандартни процеси около големи сложни набори от данни a анализатор на големи данни трябва да се справя. Има много персонализиране задължително ежедневно, за да се справяте с неструктурираните данни . Кои са езиците задължително - R, Python, Java, C++, Ruby, SQL, Hive, SAS, SPSS, MATLAB, Weka, Julia, Scala.

Освен по-горе, защо се нуждаем от анализ на големи данни? Анализ на големи данни е процесът на извличане на полезна информация чрез анализиране на различни видове голяма информация комплекти. Анализ на големи данни се използва за откриване на скрити модели, пазарни тенденции и потребителски предпочитания в полза на вземането на организационни решения.

Човек може също да попита как работи анализът на големи данни?

Голяма информация идва от текст, аудио, видео и изображения. Голяма информация се анализира от организации и предприятия по причини като откриване на модели и тенденции, свързани с човешкото поведение и нашето взаимодействие с технологиите, които след това могат да бъдат използвани за вземане на решения, които влияят върху начина ни на живот, работа , и играйте.

Какво точно е анализ на данни?

Анализ на данни се отнася до качествени и количествени техники и процеси, използвани за повишаване на производителността и печалбата от бизнеса. Данни се извлича и категоризира, за да идентифицира и анализира поведението данни и моделите и техниките варират в зависимост от организационните изисквания.

Препоръчано:

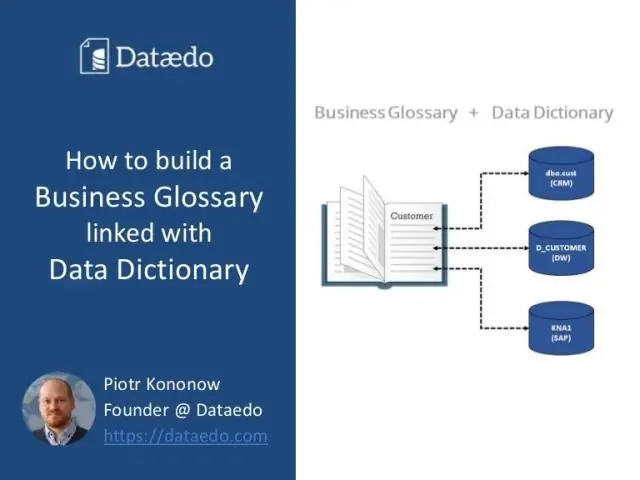

Какво е речник на данни в бизнес анализа?

Речниците на данни са RML модел на данни, който улавя подробности на ниво поле за данните в система или системи. По време на фазата на изисквания фокусът не е върху действителните данни в базата данни или техническия дизайн, необходим за реализиране на обектите с бизнес данни в базата данни

Какво представлява поглъщането на данни в големи данни?

Поглъщането на данни е процесът на получаване и импортиране на данни за незабавна употреба или съхранение в база данни. Да погълнеш нещо означава да „приемеш нещо или да погълнеш нещо“. Данните могат да се предават в реално време или да се поглъщат в пакети

Как изграждате инфраструктура за големи данни?

Ето няколко стъпки, които ще ви помогнат да поставите основна структура на големи данни, върху която можете да надграждате, докато растете. Разберете вашите приоритети. Настройте вашите системи за събиране и съхранение на данни. Уверете се, че вашата киберсигурност е солидна. Вземете решение за подход за анализ. Използвайте вашите данни. Предимства надолу

Как Hadoop се използва в анализа на данни?

Hadoop е софтуерна рамка с отворен код, която осигурява обработка на големи набори от данни в клъстери от компютри, използвайки прости модели за програмиране. Hadoop е проектиран да разшири мащаба от единични сървъри до хиляди машини

Как анализите на R са подходящи за големи данни?

R включва голям брой пакети с данни, функции за графики на рафтове и т.н., което се доказва като опитен език за анализ на големи данни, тъй като има ефективна способност за обработка на данни. Технологични гиганти като Microsoft, Google използват R за анализ на големи данни