Съдържание:

- Автор Lynn Donovan [email protected].

- Public 2023-12-15 23:43.

- Последно модифициран 2025-01-22 17:18.

За да активирате сървъра за история на Spark:

- Създайте директория за регистрационни файлове на събития във файловата система DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events.

- Когато регистрирането на събития е активирано, поведението по подразбиране е всички регистрационни файлове да бъдат запазени, което води до увеличаване на паметта с течение на времето.

Освен това, как да настроя сървър на Spark History?

За да активирате сървъра за история на Spark:

- Създайте директория за регистрационни файлове на събития във файловата система DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events.

- Когато регистрирането на събития е активирано, поведението по подразбиране е всички регистрационни файлове да бъдат запазени, което води до увеличаване на паметта с течение на времето.

По същия начин, как да намеря URL адреса на сървъра на Spark History? Напр. за сървър за история , те обикновено биха били достъпни на сървър - url >:18080/api/v1, а за работещо приложение на адрес https://localhost:4040/api/v1. В приложния програмен интерфейс (API) приложението се препраща от неговия идентификатор на приложение, [app-id].

По същия начин, какво е Spark History сървър?

В Сървърът за история на Spark е инструмент за наблюдение, който показва информация за завършени Искра приложения. Тази информация е изтеглени от данните, които приложенията по подразбиране записват в директория на Hadoop Distributed File System (HDFS).

Какво е Sparkui?

Spark Web UI ви позволява да видите списък с етапи и задачи на планировчика, информация за околната среда, информация за работещите изпълнители и др. Гледайте тази 30-минутна демонстрация, за да научите за: Компоненти и жизнен цикъл на програма Spark. Как вашето приложение Spark работи в клъстер Hadoop.

Препоръчано:

Как да проверя използването на процесора на сървъра?

За да проверите използването на процесора и физическата памет: Щракнете върху раздела Performance. Щракнете върху монитора на ресурсите. В раздела Монитор на ресурсите изберете процеса, който искате да прегледате, и навигирайте през различните раздели, като например Диск или Мрежа

Как да деактивирам прокси сървъра на iPhone?

3. Докоснете синия кръг вдясно от BlakeAcad, за да отворите разширените настройки за мрежата на BlakeAcad. 4. Натиснете бутона Изключване под HTTP прокси, за да изключите прокси сървъра

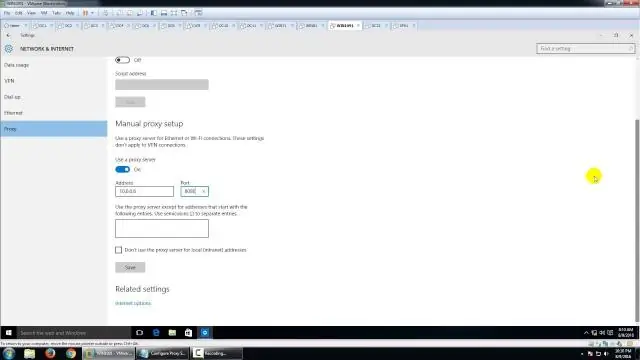

Как да коригирам настройките на прокси сървъра на Windows?

Нека да разгледаме настройките на прокси сървъра на Windows и стъпките за поправяне на това. Рестартирайте компютъра и рутера. Прегледайте настройките на прокси сървъра в Windows. Стартирайте инструмента за отстраняване на неизправности с мрежовия адаптер. Автоматично получаване на IP адрес и DNS. Актуализирайте или върнете обратно вашия мрежов драйвер. Нулирайте мрежовата конфигурация чрез командния ред

Как да настроя няколко прокси сървъра?

Използване на множество прокси сървъри Влезте в интернет и насочете уеб браузъра си към уебсайта за защитна стена на прокси (вижте ресурси). Изтеглете и инсталирайте Proxy Firewall. Добавете вашите прокси сървъри към софтуера на защитната стена на прокси. Конфигурирайте индивидуални правила за всяка програма на вашия компютър

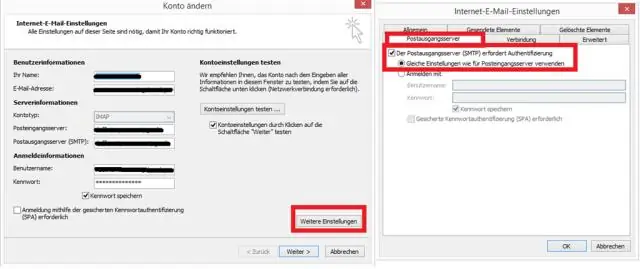

Как да намеря името на сървъра на Outlook Exchange 2016?

Щракнете върху „Инструменти > Опции“. Щракнете върху раздела „Настройка на пощата“, разположен в „Опции“, след което щракнете върху „Акаунти за електронна поща“. Щракнете върху бутона „Промяна“, разположен над „MicrosoftExchange“. Намерете текста до „MicrosoftExchange Server“. Вече намерихте името на сървъра за Microsoft Exchange